Pas op voor overfitting. Een nauwkeuriger model van verzamelde gegevens van een systeem is misschien geen betere voorspeller van toekomstig gedrag van een systeem.

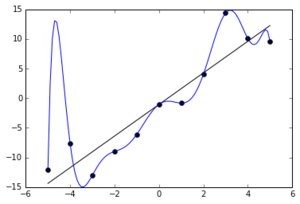

De bovenstaande afbeelding toont twee modellen van sommige gegevens.

De lineaire lijn is enigszins nauwkeurig op de trainingsgegevens (de punten op de grafiek), en (je zou verwachten) het zal enigszins nauwkeurig zijn op de testgegevens (waar de punten zijn waarschijnlijk voor x < 5 en x> -5).

Daarentegen is de polynoom 100% nauwkeurig voor de trainingsgegevens, maar (tenzij je enige reden hebt om aan te nemen dat de 9e graads polynoom redelijk is om een fysieke reden), zou je aannemen dat dit een extreem slechte voorspeller is voor x> 5 en x < -5.

Het lineaire model is 'minder nauwkeurig', gebaseerd op elke vergelijking van fouten met de gegevens die we hebben verzameld. Maar het is meer generaliseerbaar.

Bovendien hoeven ingenieurs zich minder zorgen te maken over hun model, en meer over wat mensen met het model zullen doen.

Als ik je vertel dat we een wandeling maken op een warme dag en het duurt naar verwachting 426 minuten. U zult waarschijnlijk minder water meenemen dan wanneer ik u vertel dat de wandeling 7 uur zal duren, en zelfs minder dan wanneer ik zeg dat de wandeling 4-8 uur zal duren. Dit komt doordat u reageert op mijn impliciete vertrouwen in mijn voorspelling, en niet op het midden van mijn vermelde tijden.

Als u mensen een nauwkeurig model geeft, verkleinen mensen hun foutmarge. Dit leidt tot grotere risico's.

De wandeling bijvoorbeeld op een warme dag maken, als ik weet dat de wandeling in 95% van de gevallen 4-8 uur zal duren, met enige onzekerheid over navigatie en loopsnelheid. Het perfect kennen van onze loopsnelheid zal de onzekerheid van het cijfer 4-8 verkleinen, maar het heeft geen significant effect op de 'kans dat we er zo lang over doen dat water een probleem wordt', omdat dat bijna volledig wordt aangedreven door de onzekere navigatie, niet de onzekere loopsnelheid.